- Az Nvidia hétfőn bemutatta a H200-at, a GPU-t, amelyet arra terveztek, hogy a generatív mesterségesintelligencia fellendülését biztosító AI modellek típusait képezze és telepítse.

- A H200 141 GB új generációs „HBM3” memóriát tartalmaz, amely segít szöveget, képeket vagy előrejelzéseket generálni AI modellek segítségével.

- Az Nvidia mesterséges intelligenciával hajtott GPU-i iránti érdeklődés fokozta a vállalat lendületét, az eladások várhatóan 170%-kal nőnek ebben a negyedévben.

Jensen Huang, az Nvidia elnöke a generatív AI-ban használt Grace hopper chip CPU-t tartja a Supermicro vitaindító előadásán a Computex 2023 során.

Walid Barazek | Rocket Lite | Getty Images

Az Nvidia hétfőn bemutatta a H200-at, a GPU-t, amelyet arra terveztek, hogy a generatív mesterségesintelligencia fellendülését biztosító AI modellek típusait képezze és telepítse.

Az új GPU a H100 frissítése, amely chipet az OpenAI a legfejlettebb nagy nyelvi modelljének, a GPT-4-nek a betanításához használt. Nagy cégek, startupok és kormányzati szervek versenyeznek a korlátozott chipkészletért.

Raymond James becslése szerint a H100 chipek ára 25 000 és 40 000 dollár között van, és több ezerre van szükség belőlük ahhoz, hogy együtt dolgozhassanak a legnagyobb modellek létrehozásához az úgynevezett „tréning” folyamat során.

Az Nvidia mesterséges intelligenciával működő GPU-i körüli izgalom miatt a cég részvényei szárnyaltak, amelyek 2023-ban eddig több mint 230%-kal emelkedtek. Az Nvidia mintegy 16 milliárd dolláros bevételre számít a pénzügyi harmadik negyedévben, ami 170%-os növekedés a tavalyi évhez képest.

A H200 fő fejlesztése az, hogy 141 GB új generációs „HBM3” memóriát tartalmaz, amely segít a chipnek „heurisztikák” végrehajtásában, vagy egy nagy modell használatában, miután betanították szövegek, képek vagy előrejelzések generálására.

Az Nvidia szerint a H200 csaknem kétszer olyan gyorsan fog kimenni, mint a H100. Ez a Meta’s Llama 2 LLM-mel végzett tesztelésen alapul.

A H200, amely várhatóan 2024 második negyedévében jelenik meg, felveszi a versenyt az AMD MI300X GPU-jával. Az AMD lapka a H200-hoz hasonlóan több memóriával rendelkezik az elődeihez képest, ami segít a nagyméretű modelleknek a hardveren való elhelyezésében a következtetés lefuttatásában.

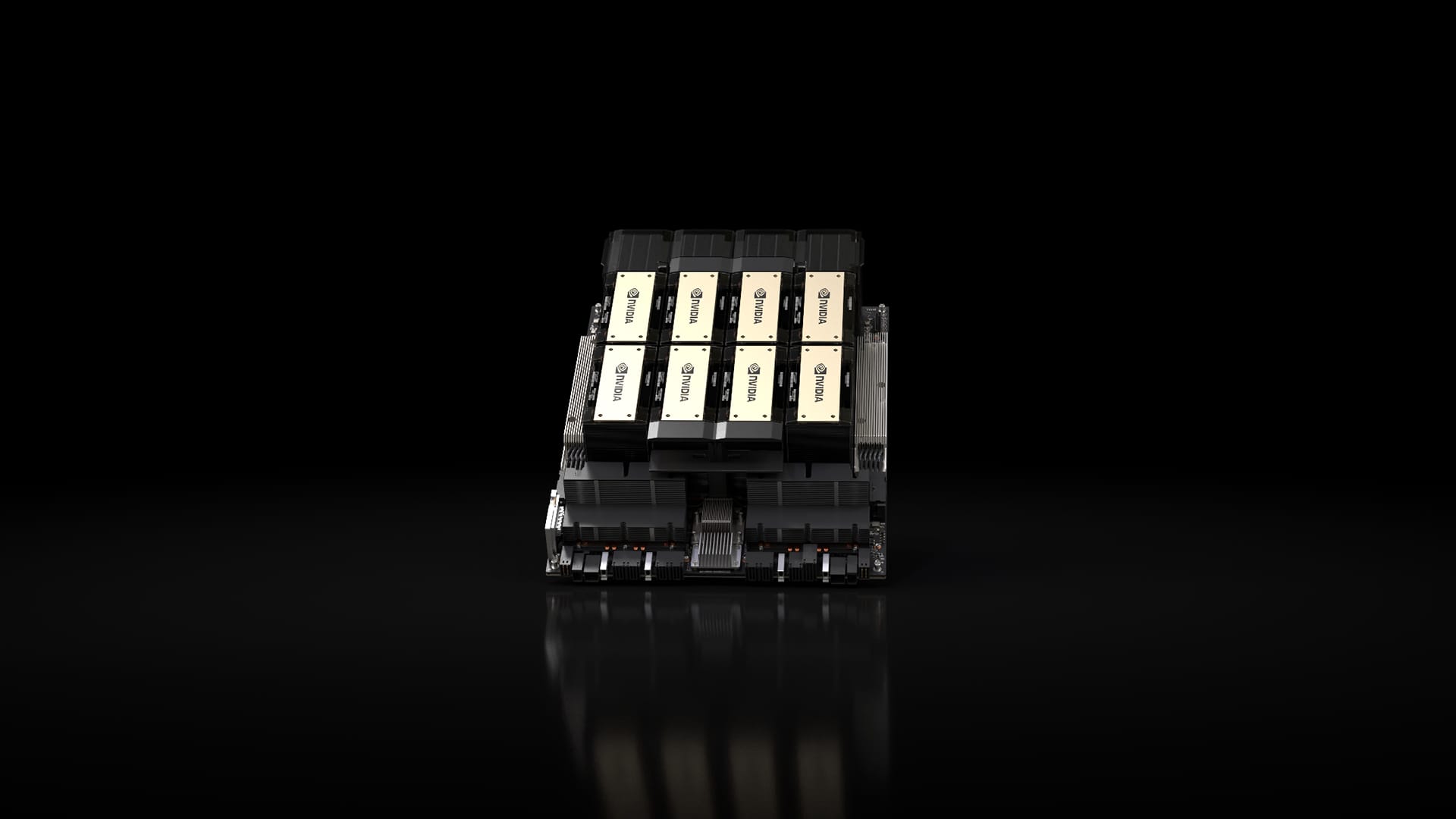

Nvidia H200 lapkakészlet nyolc GPU-s Nvidia HGX rendszerben.

Nvidia

Az Nvidia szerint a H200 kompatibilis lesz a H100-zal, ami azt jelenti, hogy az AI-nak, amely már az előző modellen oktat, nem kell módosítaniuk szerverrendszerüket vagy szoftverüket az új verzió használatához.

Az Nvidia szerint négy GPU-s vagy nyolc GPU-s szerverkonfigurációban lesz elérhető a vállalat teljes HGX rendszerein, valamint a GH200 nevű chipben, amely a H200 GPU-t egy Arm-alapú processzorral köti össze.

Előfordulhat azonban, hogy a H200 nem sokáig tartja meg a leggyorsabb Nvidia AI chip koronáját.

Míg az olyan cégek, mint az Nvidia, számos különféle konfigurációt kínálnak chipjeikhez, az új félvezetők gyakran körülbelül kétévente tesznek nagy lépést előre, amikor a gyártók egy másik architektúrára térnek át, amely jelentősebb teljesítménynövekedést tesz lehetővé, mint a memória bővítése vagy más kisebb fejlesztések. A H100 és a H200 az Nvidia Hopper architektúráján alapul.

Októberben az Nvidia közölte a befektetőkkel, hogy a GPU-i iránti nagy kereslet miatt a kétéves építészeti ütemezésről az egyéves kiadási mintára tér át. A cég felajánlotta Dia javasolja 2024-ben jelenti be és kiadja B100 chipjét, amely a közelgő Blackwell architektúrára épül.

Nézi: Erősen hiszünk a jövő évben beinduló AI-trendben

Ne hagyja ki ezeket a CNBC PRO történeteket:

„Utazási specialista. Tipikus közösségi média tudós. Az állatok barátja mindenhol. Szabadúszó zombinindzsa. Twitter-barát.”

More Stories

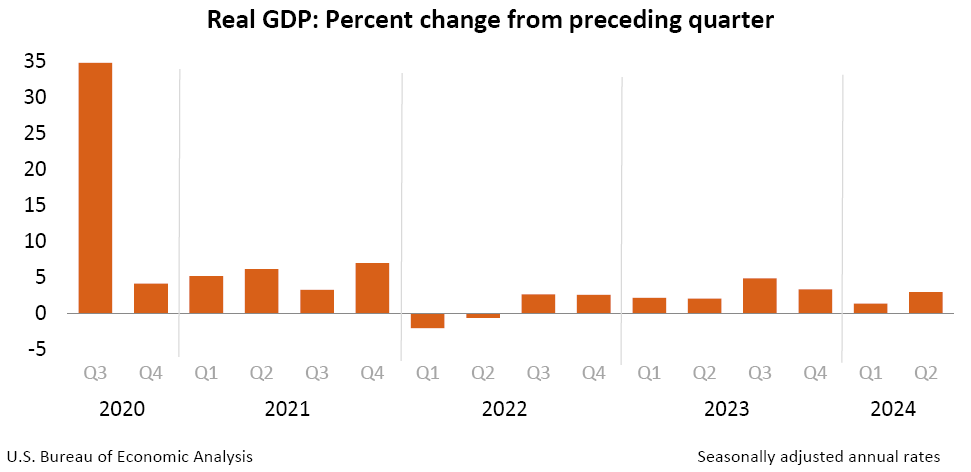

GDP (második becslés), vállalati nyereség (előzetes becslés), 2024 II

Az Nvidia bevételeinek összefoglalója: A vezérigazgató Blackwellről beszél, de nem felel meg a legmagasabb elvárásoknak

Csökken a Nasdaq és az S&P 500 részvényei az Nvidia csalódást keltő eredménye előtt