Szerdán a Google bemutatta PaLM2, amely az OpenAI GPT-4 modelljéhez hasonlítható alapvető nyelvi modellek családja. A Google I/O eseményén a kaliforniai Mountain View-ban a Google felfedte, hogy már PaLM 2-t használ 25 termék, köztük a társalgási AI-asszisztens, Bard működtetésére.

A nagy nyelvi modellek (LLM-ek) családjaként a PaLM 2-t hatalmas mennyiségű adatra képezték ki, és végrehajtja a következő szó előrejelzését, amely a legvalószínűbb szöveget állítja elő az emberek gyors bevitele után. A PaLM a Pathways Language Model és aárkáda Google által létrehozott gépi tanulási technológia. A PaLM 2 nyomon követi a fájlokat Az eredeti PaLMA Google bejelentette 2022 áprilisában.

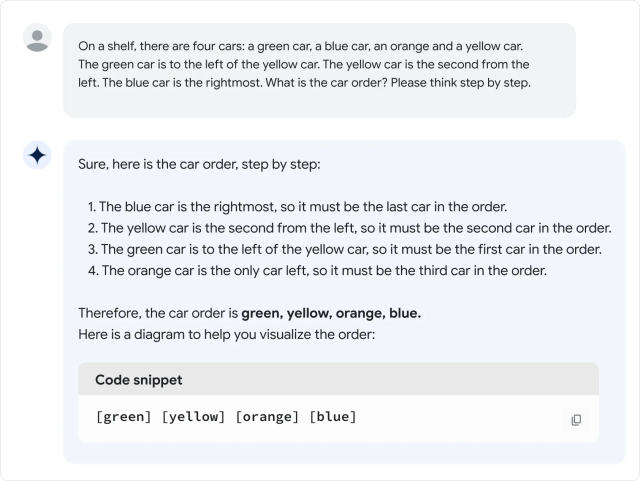

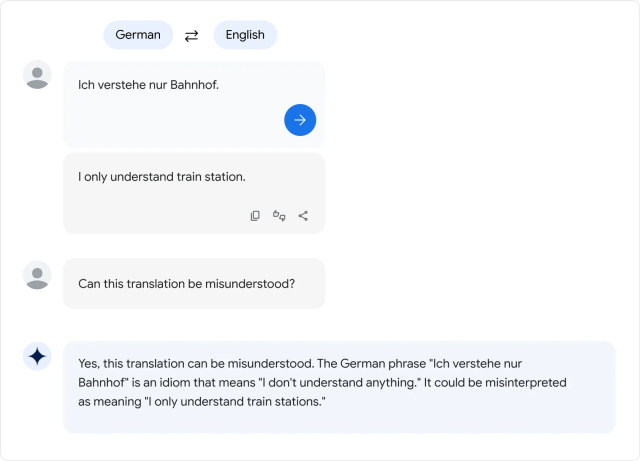

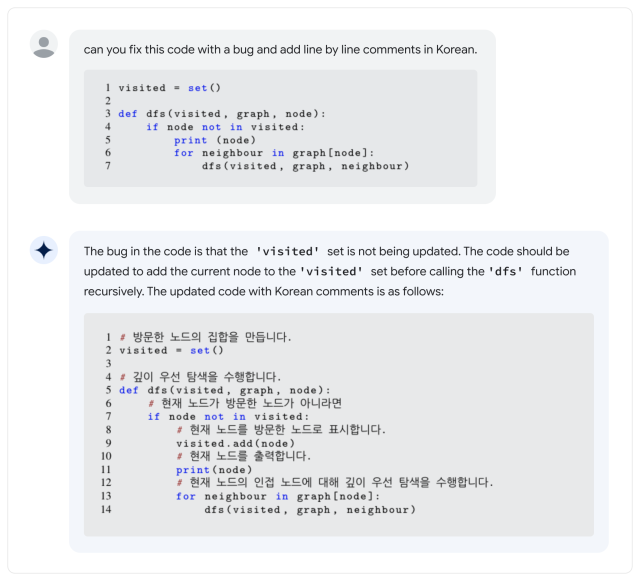

A Google szerint a PaLM 2 több mint 100 nyelvet támogat, és képes „logikai érvelésre”, kódgenerálásra és többnyelvű fordításra. Sundar Pichai, a Google vezérigazgatója a Google I/O 2023 rendezvényen tartott vitaindító előadása során elmondta, hogy a PaLM 2 négy méretben kapható: Gecko, Otter, Bison és Unicorn. A Gecko a legkisebb, és mobileszközön is játszható. A Bard mellett a PaLM 2 az AI-funkciók mögött áll a dokumentumokban, táblázatokban és prezentációkban.

Ez mind szép és jó, de hogyan képes a PaLM 2 összerakni a GPT-4-et? Ban,-ben PaLM technikai jelentés 2PaLM2 Úgy tűnik A GPT-4 legyőzése néhány matematikai, fordítási és következtetési feladatban. De a valóság nem feltétlenül felel meg a Google szabványainak. A Bard PaLM 2 verziójának gyors értékelésében Ethan Mollick, a mesterséges intelligenciáról gyakran író whartoni professzor úgy találta, hogy a PaLM 2 rosszabbul teljesít, mint a GPT-4 és a Bing számos informális nyelvi teszten, ami Zsanér a Twitter-szálban.

Egészen a közelmúltig a PaLM nyelvi modellcsalád a Google Research belső terméke volt, amely nem volt kitéve a fogyasztóknak, de a Google elkezdte Korlátozott hozzáférést biztosít az API-hoz márciusban. Az első PaLM azonban hatalmas méretéről volt híres: 540 milliárd paraméter. A paraméterek olyan numerikus változók, amelyek a modell megszerzett „tudásaként” szolgálnak, lehetővé téve a modell számára, hogy előrejelzéseket készítsen és szkriptet generáljon a kapott bemenet alapján.

A több paraméter nagyjából több bonyolultságot jelent, de nincs garancia arra, hogy hatékonyan használják őket. Összehasonlításképpen, az OpenAI GPT-3 (2020-ban) 175 milliárd paraméterrel rendelkezik. Az OpenAI soha nem hozta nyilvánosságra a GPT-4 paramétereinek számát.

És ez elvezet a nagy kérdéshez: Mennyire „nagy” a PaLM 2 a paraméterek számát tekintve? Google ne monddami egyeseket frusztrált Iparági szakértők akik gyakran kampányolnak a nagyobb átláthatóságért, hogy mi okozza az AI-modelleket.

Nem ez az egyetlen PaLM 2 funkció, amelyet a Google nem hagyott figyelmen kívül. vállalat Mondja azt mondja, hogy a PaLM 2-t „különféle forrásokra képezték ki: webes dokumentumok, könyvek, kódok, matematikai és beszélgetési adatok”, de nem részletezi, hogy pontosan mik is ezek az adatok.

A többi nagy nyelvi modell adatkészlethez hasonlóan a PaLM 2 adatkészlet valószínűleg sokféle adatot tartalmaz Szerzői joggal védett anyag Engedély nélkül használták, és olyan anyagokat, amelyek károsak lehetnek lekaparni Internet. A képzési adatok kritikusan befolyásolják bármely AI-modell kimenetét, ezért egyes szakértők a nyitott adatkészletek Lehetőséget nyújthat a tudományos reprodukcióra és az etikai vizsgálatra.

„Most, hogy az LLM termékek (és nem csak kutatás), fordulóponthoz érkeztünk: a profitorientált vállalatok *konkrétan* kevésbé lesznek átláthatók a legfontosabb összetevőket illetően.” csipog Jesse Dodge, kutató tudós Allen Mesterséges Intelligencia Intézet. „Csak ha a nyílt forráskódú közösség együtt tud szervezkedni, akkor tudunk lépést tartani!”

A titkos szósz elrejtésével kapcsolatos kritikák mindeddig nem akadályozták meg a Google-t az AI-modellek széles körű elterjedésében, annak ellenére, hogy az LLM-ek hajlamosak a semmiből kitalálni a dolgokat. A Google I/O konferencia során a vállalat képviselői bemutatták a mesterséges intelligencia funkcióit számos zászlóshajó termékében, ami azt jelenti, hogy hamarosan a nyilvánosság széles rétege küzdhet meg az AI-problémákkal.

És ami az LLM-eket illeti, a PaLM 2 még korántsem a történet vége: az I/O vitaindítón Pichai megemlítette, hogy egy új multimédiás mesterséges intelligencia-modell, a „Gemini” éppen képzés alatt áll. Ahogy a mesterséges intelligencia dominanciájáért folytatott verseny folytatódik, a Google felhasználói az Egyesült Államokban és 180 másik ország (az idegen kivéve Kanada és Európa szárazföldi része) lehet Próbáld ki maguk a PaLM 2-t A Google Bard, a kísérleti AI-asszisztens részeként.

„Odaadó úttörő az utazásokban. Szabadúszó sörtudós. Szenvedélyes elemző. Kemény twitter-fanatikus.”

More Stories

Fekete mítosz: A Wukong 1.0.8.14860 frissítés néhány fontos javítást tartalmaz, és különösen egy főnököt gyengít

A Castlevania Dominus Collection fizikai megjelenése megerősítve, az előrendelések a következő hónapban indulnak

Az iPhone 16 még nem jelent meg, és valójában van miért várni az iPhone 17 megjelenéséig